Tener un LLM de IA a mano es como tener un senior pegado a tu teclado 24/7: responde dudas, te sugiere código y hasta te explica cosas sin juzgarte. ¿Lo mejor? Hoy puedes correr un modelo gordote sin conexión y tener tu propio ChatGPT casero, listo para funcionar aunque se caiga Internet (o tu jefe corte el wifi).

Pero… ¿qué es exactamente eso de “un modelo gordote”? Estamos hablando de los LLM o Large Language Models. Básicamente, son modelos de inteligencia artificial entrenados con chorrocientos millones (a veces billones) de palabras para entender y generar texto como si fueran humanos. Les das un prompt y te devuelven una respuesta que parece escrita por una persona (con cafeína y sin errores ortográficos).

Estos modelos entienden contexto, siguen instrucciones, hacen resúmenes, te generan código, corrigen mails… vamos, que son como un becario listo, pero sin sueños ni dramas. Y lo mejor: ya no necesitas los servidores de Google para usarlos. Hoy en día puedes ejecutarlos en tu propio PC y con resultados que hace solo un par de años eran ciencia ficción.

Porque sí, todos nos reímos hasta que llega el día del apagonazo nacional (hola España 👋), se cae medio Internet y de pronto no puedes trabajar porque dependías de ChatGPT hasta para nombrar variables. Spoiler: me pasó. Por eso, amigo/a dev, montar tu propio LLM local es como tener una copia de seguridad de tu cerebro.

Requisitos mínimos para no morir en el intento

| Hardware | ¿Qué necesitas? |

| GPU | 8 GB VRAM (16 GB si quieres ir sobrado) |

| Disco | 20 GB libres (modelos + cachés) |

| SO | Linux / macOS |

| Extras | Python 3.10+, Git, curl, brew, café ☕ |

¿Qué modelo me bajo, jefe?

He elegido Llama 3.2 3B Instruct porque ofrece el equilibrio perfecto. Es lo bastante ligero para correr sin problemas en mi Mac (M2 Pro y 16 GB de RAM), pero lo bastante potente como para ayudarte con tareas de programación, explicaciones técnicas y respuestas naturales, todo sin depender de la nube ni freírte la RAM.

Cómo levantar Llama 3.2 3B Instruct en local

Vamos a usar Ollama. Es la forma más fácil y rápida de correr modelos de lenguaje (LLMs) en local, sin tener que pelearte con compilaciones raras, dependencias chungas ni configurar media docena de cosas. Literalmente con dos comandos ya tienes un modelo descargado y funcionando.

¿Por qué usarlo? Porque funciona nativamente en macOS con Apple Silicon, aprovecha Metal para que todo vaya fluido, gestiona los modelos por ti y encima es compatible con herramientas como Open WebUI si quieres una interfaz más visual. Básicamente: si quieres levantar un LLM en local y no quieres complicarte la vida, Ollama es tu mejor aliado.

Usando el terminal

1. Instalar Ollama

a. Lanzar el comando brew install ollama para instalar.

b. Iremos a la web de Ollama y nos bajaremos el instalador para nuestro SO.

2. Arrancar Ollama (omitir paso si has usado el instalador)

Bastara con usar el comando OLLAMA_FLASH_ATTENTION="1" OLLAMA_KV_CACHE_TYPE="q8_0" ollama serve &.

3. Descargar el modelo

Para ello deberemos ejecutar en el terminal el comando ollama pull llama3:instruct

4. ¡A rodar!

Con ejecutar ollama run llama3:instruct ya podremos interactuar con el LLM directamente desde nuestro terminal.

Si prefieres usar una interfaz gráfica, continúa con la siguiente sección.

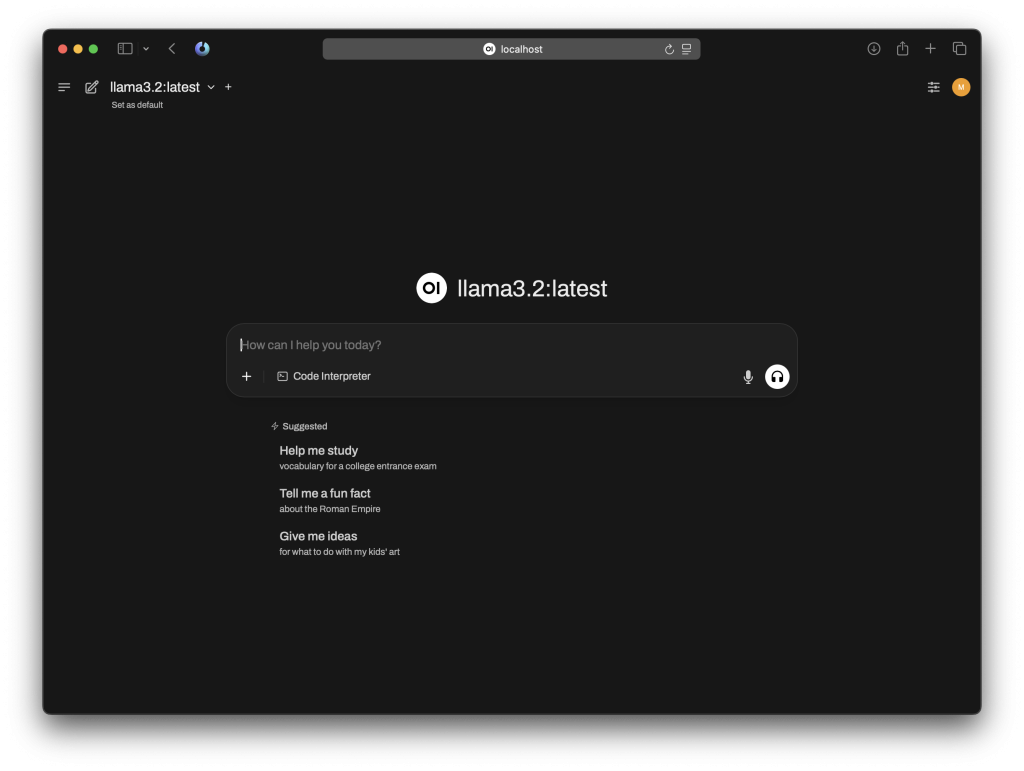

Instalar Open WebUI

Solo tienes que seguir las instrucciones de instalación.

Con eso tendrás un modelo funcionando en tu máquina, con una interfaz gráfica muy similar a otras, todo offline y completamente gratis.

Lee más en nuestro blog.